カテゴリ: 環境構築

1 / 2 ページずるい Git GUI クライアント Fork に乗り換えた

会社で Fork という Git GUI クライアントが流行っており、ずっと使ってきた Sourcetree に進歩が見られないので思い切って乗り換えることにしました。

ここのところの Sourcetree は割とモサモサしていたり、画面構成も v2 のころのほうが個人的に使いやすいと思っていたりで不満がありました。 CLI だけで Git を使っていくこともできますが、樹形図表示や行単位のステージ操作などには GUI が欲しくなります。

Sourcetree に比べると知名度が全然の Fork ですが、非常に出来の良いソフトウェアでした。 …

macOS Sequoia で rsync が openrsync に置換され一部スクリプトが機能しなくなった件

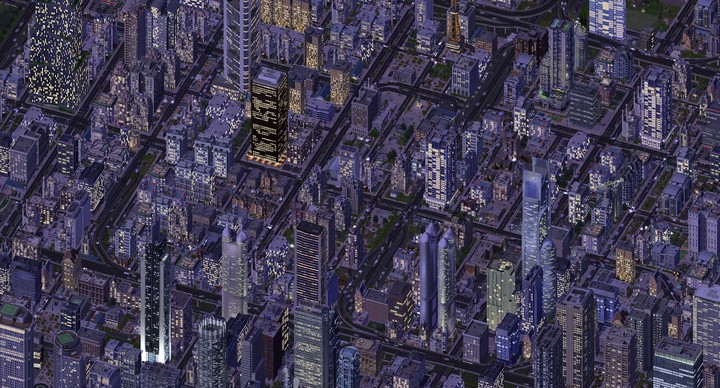

GOG 版 SimCity 4 に旧日本語パッケージ版コンテンツを統合して移行

GOG 版などのデジタルリリースされた SimCity 4 Deluxe では、プログラムの難読化が緩いらしく、コミュニティによる DLL ベースの MOD 開発はこれらデジタル版1のみを対象するように移行していく風潮です。

発売から 20 年経過しても MOD コミュニティが活発であることが喜ばしい一方で、これらデジタルリリース版には日本語コンテンツが収録されていないので、英語テキストでのプレイを強制されます2。

幸い日本語版を所持していれば、デジタル版へのコンテンツの統合が簡単に行えるので、日本語版で DLL 時代を迎える方法をここに記します。ここでは、旧版がインストール済みの環境で GOG 版を追加購入して実行しています。 Steam 版1でも同じようにできると思いますが、GOG 版は DRM が無いので Steam 版よりもおすすめです。 …

日本語 DeepSeek-R1 Qwen 蒸留 32B のローカル実行を試す

macOS Sonoma で m4 が使用できなかった件

ELYZA Japanese LLaMA 2 13B を WEB デプロイ

ELYZA Japanese LLaMA 2 の 13B モデルがリリースされたのでお試しです。量子化済みモデルの中から fast-instruct-q5_K_M を選びました。

7B を扱った先回記事とだいたい同じ内容を Ubuntu で行っています。

Llama.cpp の Python バインディング (CPU) である llama-cpp-python は OpenAI 互換の API サーバーを内蔵しているので、ここに Chatbot UI (WEB フロントエンド) を接続することで、ChatGPT サービスのように WEB から ELYZA Japanese LLaMa 2 を使うことができます1。 …

ELYZA Japanese LLaMA 2 (CPU) を Chatbot UI から遊ぶ

先回記事の続きです。前回紹介した Elyza の日本語言語モデル ELYZA Japanese LLaMa 2 を Chatbot UI から使えるようにしてみました。

Llama.cpp の Python バインディングである llama-cpp-python は OpenAI 互換の API サーバーを内蔵しているので、ここに Chatbot UI を接続することで、ChatGPT のように WEB から ELYZA Japanese LLaMa 2 を使うことができます1。 …

Japanese StableLM Instruct Alpha 7B v2 のローカル GPU 実行を試す

Stability AI より Japanese StableLM Instruct Alpha 7B v2 がリリースされたので、期待を込めてサクッと試しました。 …

LLaMA 2 日本語モデルを CPU 実行する

M2 MacBook Pro にて、Llama.cpp を使い量子化済みの LLaMA 2 派生モデルを実行することに成功したので手順をメモします。 Llama.cpp は言語モデルをネイティブコードによって CPU 実行するためのプログラムであり、Apple Silicon 最適化を謳っていることもあってか、かなり高速に動かせました。 …

ELYZA Japanese LLaMA 2 のローカル実行を試す

仕事で使うかもしれないとなったので、GPU 搭載の Windows マシンで ELYZA Japanese LLaMa 2 をお試し動作させました。現時点での手順を簡潔にメモします。 …

autossh と systemd でリモートデスクトップ用のトンネルを永続化

外出先から家の PC を触りたいことがそこそこの頻度であり、autossh と systemd を使って SSH トンネルを永続化しました。インターネットに公開されている VPS に対して、自宅 LAN 内のラズパイから Windows PC へリモートデスクトップ用のトンネルを引き込み、外から PC を使えるようにしました。 …