前回記事では、オプション引数をとるデコレータを楽に定義できるデコレータである kwops_decorator を作成しました。

今回は実演がてら、Python のリトライ処理記述ライブラリ Tenacity を題材に、よく使うリトライ表現を抽象化してみます。 Tenacity は基本的に、実行対象の関数にデコレータを付けることで、その関数はリトライされるべきであることを表現するのですが、関数内でリトライ回数をカウントするためには外のスコープに変数や、クラスにインスタンス変数を置いて自分で数える必要があり、カウントのリセットなども考慮すると微妙に面倒です。そこの改善を主目的に、kwops_decorator を活用し Tenacity のデコレータをラップします。 …

画像生成の主戦場はすっかり拡散モデルですが、大学時代に作成していた「プリキュア StyleGAN」を紹介します。プロフィールアイコン程度に使える画像の生成を目標としていました。

最終形態(この記事よりもさらに追加で改善を実施)のリポジトリは以下です。 Chainer で出来ているので、保守作業がやや面倒なことになっていますが、ちゃんと動くはずです。 …

ELYZA Japanese LLaMA 2 の 13B モデルがリリースされたのでお試しです。量子化済みモデルの中から fast-instruct-q5_K_M を選びました。

7B を扱った先回記事とだいたい同じ内容を Ubuntu で行っています。

Llama.cpp の Python バインディング (CPU) である llama-cpp-python は OpenAI 互換の API サーバーを内蔵しているので、ここに Chatbot UI (WEB フロントエンド) を接続することで、ChatGPT サービスのように WEB から ELYZA Japanese LLaMa 2 を使うことができます1。 …

Python の型ヒントには、ジェネリック型も存在します。しかし、現在の Python の実装では、ジェネリック型のインスタンスやクラスには、実行時に型パラメータの情報は一切残っていない(型消去的動作)です。

本記事では、Python のジェネリック型の型注釈で実行時に型パラメータを取れるようにする方法を紹介します。 …

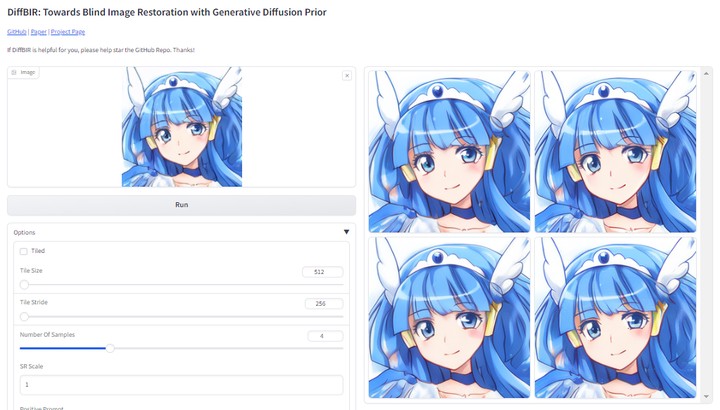

DiffBIR は、拡散過程に基づく画像復元モデルです。 Stable Diffusion の重みを利用しているようです。 …

先回記事の続きです。前回紹介した Elyza の日本語言語モデル ELYZA Japanese LLaMa 2 を Chatbot UI から使えるようにしてみました。

Llama.cpp の Python バインディングである llama-cpp-python は OpenAI 互換の API サーバーを内蔵しているので、ここに Chatbot UI を接続することで、ChatGPT のように WEB から ELYZA Japanese LLaMa 2 を使うことができます1。 …

Stability AI より Japanese StableLM Instruct Alpha 7B v2 がリリースされたので、期待を込めてサクッと試しました。 …

M2 MacBook Pro にて、Llama.cpp を使い量子化済みの LLaMA 2 派生モデルを実行することに成功したので手順をメモします。 Llama.cpp は言語モデルをネイティブコードによって CPU 実行するためのプログラムであり、Apple Silicon 最適化を謳っていることもあってか、かなり高速に動かせました。 …

仕事で使うかもしれないとなったので、GPU 搭載の Windows マシンで ELYZA Japanese LLaMa 2 をお試し動作させました。現時点での手順を簡潔にメモします。 …